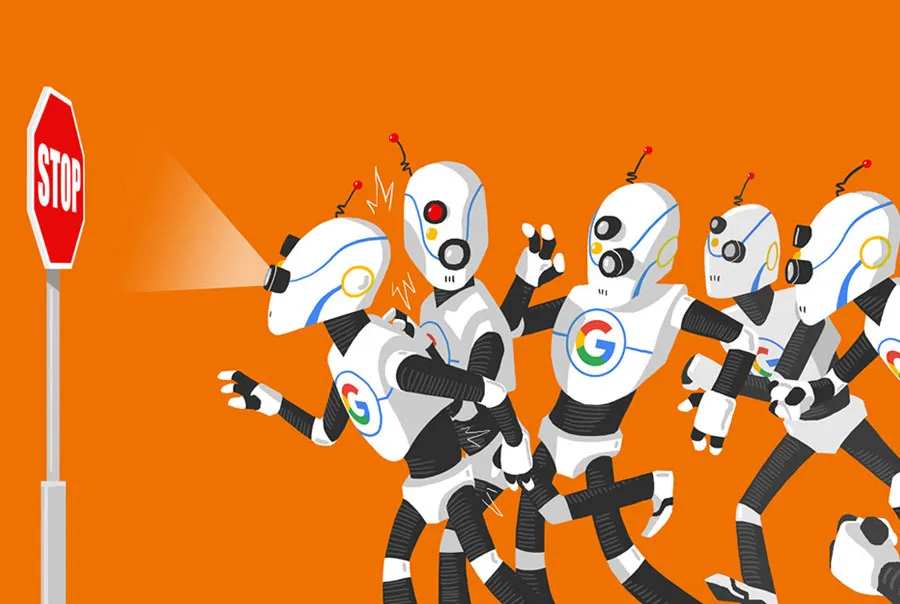

وب سایت ها از بخش های مختلفی تشکیل شدهاند که همه آن ها نیاز به دیده شدن توسط کاربران یا موتور های جستجو ندارند. موتور های جستجو، مانند گوگل، بینگ و یاهو، با استفاده از ربات های خود، صفحات مختلف وب سایتها را می خوانند و اطلاعات آن ها را ایندکس می کنند تا کاربران بتوانند محتوای مناسب را در نتایج جستجو پیدا کنند. اما در برخی موارد، مدیران وب سایت نمی خواهند که تمام صفحات سایت توسط این ربات ها مشاهده شوند. فایل robots.txt ابزاری ساده و مؤثر است که به مدیران وب سایت اجازه می دهد بخش های خاصی از سایت خود را از دسترسی ربات های موتور جستجو مخفی کنند.

فایل robots.txt چیست؟

فایل robots.txt یک فایل متنی ساده است که در ریشه وب سایت قرار می گیرد و به موتور های جستجو می گوید که کدام صفحات و بخش های وب سایت را مجاز به مشاهده و ایندکس کردن هستند و کدام صفحات را نباید بررسی کنند. این فایل برای هدایت رفتار ربات های موتور جستجو، جلوگیری از ایندکس شدن بخشهای غیر ضروری و بهینه سازی منابع سرور استفاده می شود.

برای مثال، اگر وب سایتی دارای صفحه ای آزمایشی باشد که نیازی به دیده شدن در موتورهای جستجو ندارد، می توان در فایل robots.txt به ربات ها دستور داد که آن صفحه را نادیده بگیرند. این کار همچنین باعث میشود تا صفحات مهم تر سایت توسط موتور های جستجو بهتر دیده شوند.

چرا استفاده از robots.txt مهم است ؟

استفاده از robots.txt چندین مزیت دارد که از جمله آن ها می توان به موارد زیر اشاره کرد :

مخفی کردن صفحات خاص : فایل robots.txt امکان مخفی کردن صفحاتی که نیازی به دیده شدن در نتایج جستجو ندارند را فراهم می کند. به عنوان مثال، صفحات مدیریت، صفحات آزمایشی و محتوای محرمانه میتوانند از دید موتور های جستجو مخفی شوند.

صرفهجویی در منابع سرور : ربات های موتور جستجو مرتباً در حال جستجوی صفحات مختلف هستند و این کار می تواند بار زیادی را بر سرور های سایت تحمیل کند. با جلوگیری از دسترسی آن ها به بخش های غیرضروری سایت، می توان مصرف منابع سرور را کاهش داد.

بهینهسازی برای سئو (SEO) : موتور های جستجو دارای منابع محدودی برای بررسی و ایندکس صفحات سایت ها هستند. فایل robots.txt کمک می کند تا این منابع به بخش های مهم و دارای ارزش سئو هدایت شوند و در نتیجه، سایت به شکل بهتری در نتایج جستجو نمایان شود.

ساختار و نحوه کار فایل robots.txt

فایل robots.txt شامل دستوراتی است که به موتور های جستجو می گوید کدام بخش های سایت را نباید مشاهده کنند. ساختار اصلی آن بسیار ساده است و از دستوراتی مانند User-agent و Disallow استفاده می کند.

User-agent : این دستور مشخص می کند که قانون تعیین شده برای کدام موتور جستجو یا ربات اعمال شود. اگر به جای نام یک موتور جستجو، علامت * قرار داده شود، قانون برای همه ربات ها اعمال می شود.

Disallow : این دستور مسیر صفحه یا بخشی از سایت را که نمی خواهیم توسط موتورهای جستجو دیده شود مشخص می کند.

مثال های ساده

محدود کردن دسترسی به تمام سایت برای همه ربات ها :

User-agent: *

Disallow: /

این دستور به تمام ربات ها می گوید که هیچ صفحه ای از سایت را بازدید نکنند.

اجازه به همه ربات ها برای دسترسی به همه صفحات سایت:

User-agent: *

Disallow:

این دستور به همه ربات ها اجازه می دهد تا همه صفحات را بازدید کنند.

جلوگیری از دسترسی به بخشهای خاص:

User-agent: *

Disallow: /admin/

Disallow: /test/

این دستور به همه ربات ها می گوید که به صفحات /admin/ و /test/ دسترسی نداشته باشند.

نکات مهم درباره استفاده از فایل robots.txt

محل قرار گیری فایل : فایل robots.txt باید همیشه در ریشه اصلی سایت قرار بگیرد. به عنوان مثال: https://example.com/robots.txt.

عدم تضمین امنیت اطلاعات : فایل robots.txt فقط به موتور های جستجو دستور میدهد که به برخی صفحات دسترسی نداشته باشند، اما نمی تواند مانع از دسترسی تمام ربات ها شود. به همین دلیل، نباید اطلاعات حساس و محرمانه را به این روش مخفی کنید.

ابزار مدیریت دسترسی : فایل robots.txt بیشتر برای بهینهسازی و هدایت موتور های جستجو طراحی شده و نباید به عنوان ابزاری برای مدیریت کامل دسترسیها به محتوای سایت در نظر گرفته شود.

جمع بندی فایل robots.txt ابزاری ساده ولی مهم برای مدیریت رفتار موتور های جستجو در سایت است. با کمک این فایل، میتوان بخش های غیر ضروری سایت را از ایندکس شدن جلوگیری کرد و بهینه سازی سئوی سایت را افزایش داد. با این حال، این فایل نمیتواند مانع دسترسی همهی ربات ها شود و برای اطلاعات حساس و محرمانه باید از روش های امنیتی دیگری استفاده کرد.

استفاده درست از robots.txt به شما کمک می کند تا سایت خود را به شکل کار آمدتری مدیریت کنید و ترافیک بهتری را از موتور های جستجو جذب کنید.